本主题介绍如何在 Microsoft® Azure Kubernetes Service (AKS) 上为 Apigee Hybrid 设置多区域部署。

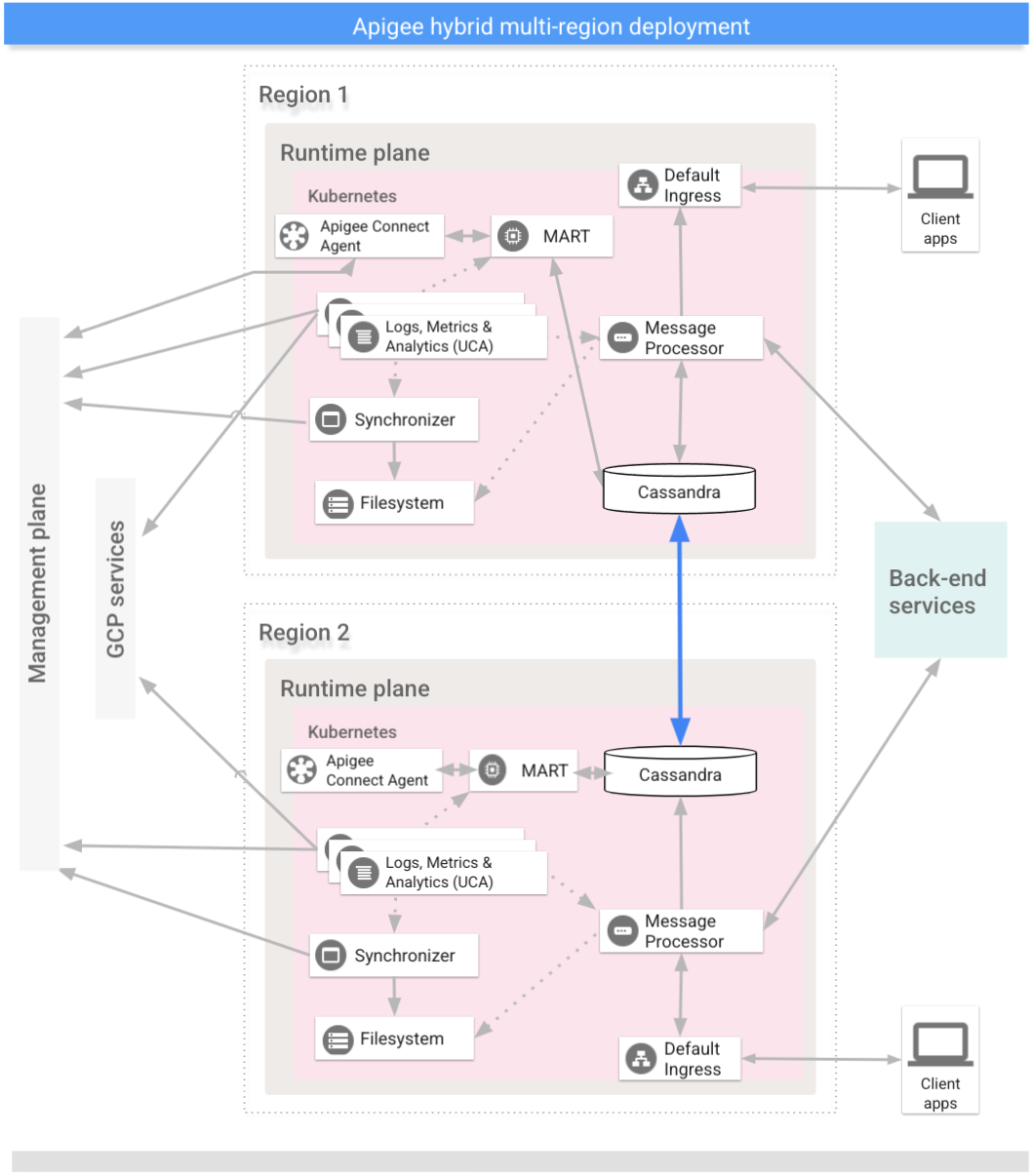

多区域部署的拓扑包括以下内容:

- 主动-主动:您的应用部署在多个地理位置,并且您的部署需要低延迟时间 API 响应时。您可以选择在距离您客户端最近的多个地理位置部署 Hybrid。例如:美国西海岸、美国东海岸、欧洲、亚太区域。

- 主动-被动:您拥有主要区域和故障切换或灾难恢复区域时。

多区域混合部署中的区域通过 Cassandra 通信,如下图所示:

前提条件

在为多个丢弃配置 Hybrid 之前,您必须先满足以下前提条件:

- 按照混合安装指南中的说明,在移到集群设置步骤之前,先满足 GCP 和组织配置等前提条件。

如需了解详情,请参阅 Kubernetes 文档。

在每个区域中创建虚拟网络

为多区域部署创建虚拟网络。例如,以下示例命令会在美国中部区域和东部区域创建网络。

执行以下命令,以在美国东部区域创建一个名为 my-hybrid-rg-vnet 的虚拟网络:

az network vnet create \ --name my-hybrid-rg-vnet \ --location eastus \ --resource-group my-hybrid-rg \ --address-prefixes 120.38.1.0/24 \ --subnet-name my-hybrid-rg-vnet-subnet \ --subnet-prefix 120.38.1.0/26

执行以下命令,以在美国中部区域创建一个名为 my-hybrid-rg-vnet-ext01 的虚拟网络:

az network vnet create \ --name my-hybrid-rg-vnet-ext01 \ --location centralus \ --resource-group my-hybrid-rg \ --address-prefixes 192.138.0.0/24 \ --subnet-name my-hybrid-rg-vnet-ext01-subnet \ --subnet-prefix 192.138.0.0/26

创建网络对等互连

在虚拟网络之间创建网络对等互连。

获取虚拟网络 ID

在虚拟网络 ID 之间建立对等互连。使用 az network vnet show 命令获取每个虚拟网络的 ID,并将该 ID 存储在变量中。

获取第一个虚拟网络的 ID,即名为 my-hybrid-rg-vnet 的网络:

vNet1Id=$(az network vnet show \ --resource-group my-hybrid-rg \ --name my-hybrid-rg-vnet \ --query id --out tsv)

获取第二个虚拟网络的 ID,即名为 my-hybrid-rg-vnet-ext01 的网络:

vNet2Id=$(az network vnet show \ --resource-group my-hybrid-rg \ --name my-hybrid-rg-vnet-ext01 \ --query id \ --out tsv)

创建从第一个到第二个虚拟网络的对等互连

使用虚拟网络 ID,您可以创建从第一个虚拟网络 (my-hybrid-rg-vnet) 到第二个 (my-hybrid-rg-vnet-ext01) 的对等互连,如以下示例所示:

az network vnet peering create \ --name my-hybrid-rg-vnet1-peering \ # The name of the virtual network peering. --resource-group my-hybrid-rg \ --vnet-name my-hybrid-rg-vnet \ # The virtual network name. --remote-vnet $vNet2Id \ # Resource ID of the remote virtual network. --allow-vnet-access

在命令的输出中,注意 peeringState 已启动。除非您创建从第二个虚拟网络回到第一个虚拟网络的对等互连,否则对等互连会保持“已启动”状态。

{

...

"peeringState": "Initiated",

...

}

创建从第二个虚拟网络到第一个虚拟网络的对等互连

示例命令:

az network vnet peering create \ --name my-hybrid-rg-vnet2-peering \ # The name of the virtual network peering. --resource-group my-hybrid-rg \ --vnet-name my-hybrid-rg-vnet-ext01 \ # The virtual network name. --remote-vnet $vNet1Id \ # Resource ID of the remote virtual network. --allow-vnet-access

在命令的输出中,注意 peeringState 已连接。此外,Azure 还会将第一个虚拟网络到第二个虚拟网络的对等互连的对等互连状态更改为已连接。

{

...

"peeringState": "Connected",

...

}

您还可以使用以下命令确认 my-hybrid-rg-vnet1-peering 到 my-hybrid-rg-vnet2-peering 的对等互连状态:对等互连已更改为“已连接”:

az network vnet peering show \ --name my-hybrid-rg-vnet1-peering \ --resource-group my-hybrid-rg \ --vnet-name my-hybrid-rg-vnet \ --query peeringState

预期输出:

Connected

创建多区域集群

在多个具有不同 CIDR 块的区域中设置 Kubernetes 集群。另请参阅第 1 步:创建集群。使用您之前创建的位置和虚拟网络名称。

在跨所有区域的 Kubernetes 集群之间打开 Cassandra 端口 7000 和 7001(在问题排查期间可能会使用 7000 作为备用选项)

配置多区域种子主机

本部分介绍如何将现有 Cassandra 集群扩展到新区域。此设置允许新区域引导集群并加入现有数据中心。如果没有此配置,多区域 Kubernetes 集群不会相互了解。

- 在检索种子名称之前,将 kubectl 上下文设置为原始集群:

kubectl config use-context original-cluster-name

运行以下

kubectl命令,确定当前区域中 Cassandra 的种子主机地址。种子主机地址允许新区域实例在第一次启动时查找原始集群,以了解集群的拓扑。种子主机地址被指定为集群中的联络点。

kubectl get pods -o wide -n apigee | grep apigee-cassandra apigee-cassandra-default-0 1/1 Running 0 4d17h 120.38.1.9 aks-agentpool-21207753-vmss000000

- 确定上一个命令返回的哪些 IP 将成为多区域种子主机。在本示例中,只有一个节点 Cassandra 集群正在运行时,种子主机为

120.38.1.9。 - 在数据中心 2 中,将替换文件复制到名称包含集群名称的新文件。例如

overrides_your_cluster_name.yaml。 - 在数据中心 2 中,在

overrides_your_cluster_name.yaml中配置cassandra.multiRegionSeedHost和cassandra.datacenter,其中multiRegionSeedHost是上一个命令返回的其中一个 IP:cassandra: multiRegionSeedHost: seed_host_IP datacenter: data_center_name rack: rack_name

例如:

cassandra: multiRegionSeedHost: 120.38.1.9 datacenter: "centralus" rack: "ra-1"

- 在新数据中心/区域中,安装 Hybrid 之前,在

overrides_your_cluster_name.yaml中设置您在第一个区域中设置的相同 TLS 证书和凭据。

设置新区域

配置种子主机后,您可以设置新区域。

要设置新区域,请执行以下操作:

- 将证书从现有集群复制到新集群。Cassandra 和其他混合组件会将新 CA 根用于 mTLS。因此,务必确保集群具有一致的证书。

- 将上下文设置为原始命名空间:

kubectl config use-context original-cluster-name

- 将当前命名空间配置导出到文件:

$ kubectl get namespace namespace -o yaml > apigee-namespace.yaml

- 将

apigee-ca密钥导出到文件:kubectl -n cert-manager get secret apigee-ca -o yaml > apigee-ca.yaml

- 将上下文设置为新区域的集群名称:

kubectl config use-context new-cluster-name

- 将命名空间配置导入新集群。如果您在新区域中使用不同的命名空间,请务必更新文件中的“命名空间”:

kubectl apply -f apigee-namespace.yaml

将密钥导入新集群:

kubectl -n cert-manager apply -f apigee-ca.yaml

- 将上下文设置为原始命名空间:

- 在新区域中安装 Hybrid。确保

overrides_your_cluster_name.yaml文件包含在第一个区域中配置的相同 TLS 证书,如上一部分所述。执行以下两个命令以在新区域中安装 Hybrid:

apigeectl init -f overrides_your_cluster_name.yaml

apigeectl apply -f overrides_your_cluster_name.yaml

- 在新数据中心的所有节点上运行

nodetool rebuild。这可能需要几分钟到几小时的时间,具体取决于数据大小。kubectl exec apigee-cassandra-default-0 -n apigee -- nodetool -u JMX_user -pw JMX_password rebuild -- dc-1

其中 JMX_user 和 JMX_password 是 Cassandra JMX 用户的用户名和密码。

- 从日志中验证重建进程。此外,使用

nodetool status命令验证数据大小:kubectl logs apigee-cassandra-default-0 -f -n apigee

kubectl exec apigee-cassandra-default-0 -n apigee -- nodetool -u JMX_user -pw JMX_password status

以下示例显示了日志条目示例:

INFO 01:42:24 rebuild from dc: dc-1, (All keyspaces), (All tokens) INFO 01:42:24 [Stream #3a04e810-580d-11e9-a5aa-67071bf82889] Executing streaming plan for Rebuild INFO 01:42:24 [Stream #3a04e810-580d-11e9-a5aa-67071bf82889] Starting streaming to /10.12.1.45 INFO 01:42:25 [Stream #3a04e810-580d-11e9-a5aa-67071bf82889, ID#0] Beginning stream session with /10.12.1.45 INFO 01:42:25 [Stream #3a04e810-580d-11e9-a5aa-67071bf82889] Starting streaming to /10.12.4.36 INFO 01:42:25 [Stream #3a04e810-580d-11e9-a5aa-67071bf82889 ID#0] Prepare completed. Receiving 1 files(0.432KiB), sending 0 files(0.000KiB) INFO 01:42:25 [Stream #3a04e810-580d-11e9-a5aa-67071bf82889] Session with /10.12.1.45 is complete INFO 01:42:25 [Stream #3a04e810-580d-11e9-a5aa-67071bf82889, ID#0] Beginning stream session with /10.12.4.36 INFO 01:42:25 [Stream #3a04e810-580d-11e9-a5aa-67071bf82889] Starting streaming to /10.12.5.22 INFO 01:42:26 [Stream #3a04e810-580d-11e9-a5aa-67071bf82889 ID#0] Prepare completed. Receiving 1 files(0.693KiB), sending 0 files(0.000KiB) INFO 01:42:26 [Stream #3a04e810-580d-11e9-a5aa-67071bf82889] Session with /10.12.4.36 is complete INFO 01:42:26 [Stream #3a04e810-580d-11e9-a5aa-67071bf82889, ID#0] Beginning stream session with /10.12.5.22 INFO 01:42:26 [Stream #3a04e810-580d-11e9-a5aa-67071bf82889 ID#0] Prepare completed. Receiving 3 files(0.720KiB), sending 0 files(0.000KiB) INFO 01:42:26 [Stream #3a04e810-580d-11e9-a5aa-67071bf82889] Session with /10.12.5.22 is complete INFO 01:42:26 [Stream #3a04e810-580d-11e9-a5aa-67071bf82889] All sessions completed

- 更新种子主机。从

overrides-DC_name.yaml中移除multiRegionSeedHost: 10.0.0.11并重新应用。apigeectl apply -f overrides-DC_name.yaml